【论文阅读】Intelligent Physical Attack Against Mobile Robots With Obstacle-Avoidance

【论文阅读】Intelligent Physical Attack Against Mobile Robots With Obstacle-Avoidance

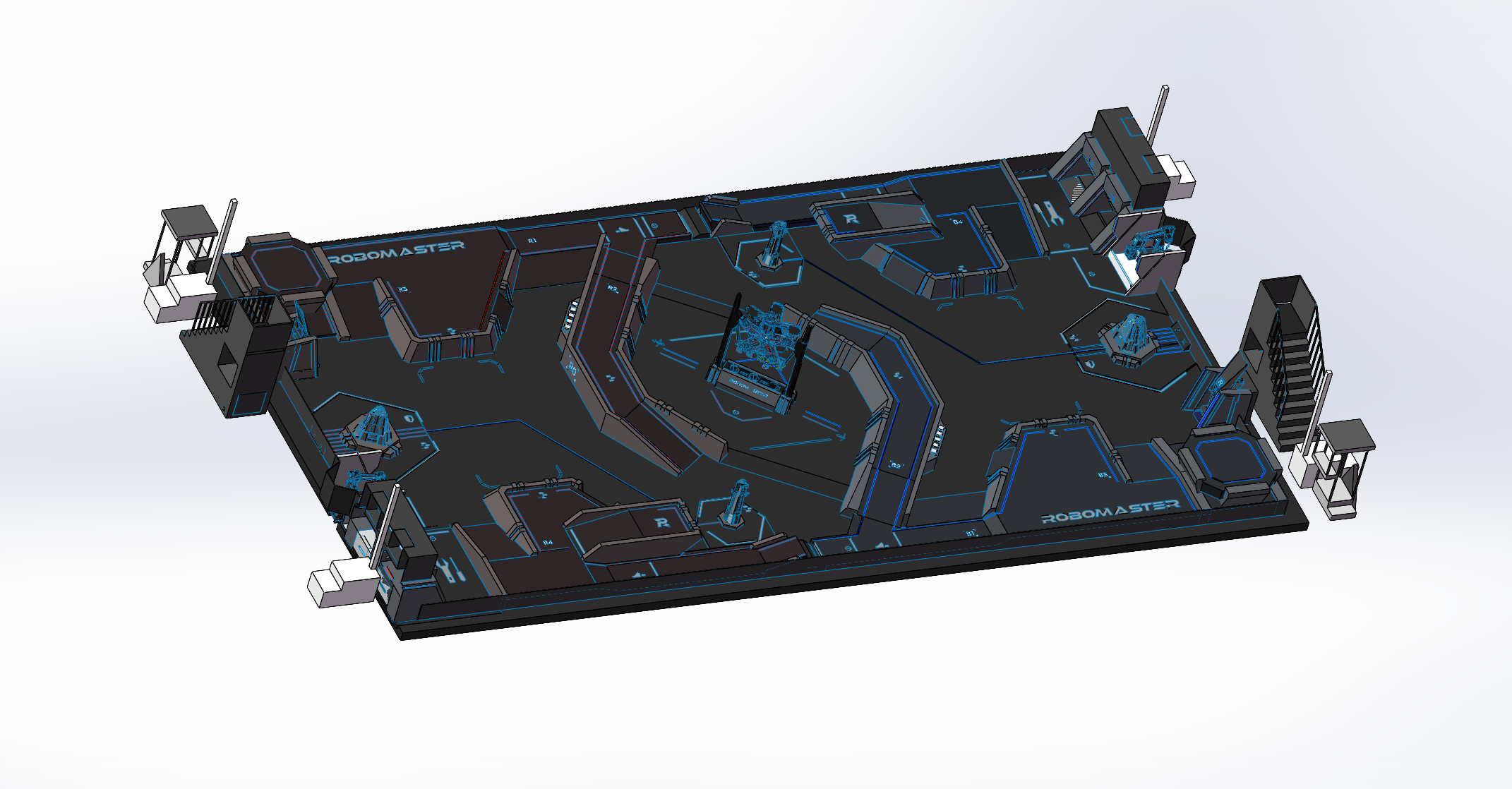

标题:Intelligent Physical Attack Against Mobile Robots With Obstacle-Avoidance

作者: Yushan Li et al.

机构:上海交通大学

来源:TRO 2022

🏷️摘要

近年来,移动机器人的安全问题引起了广泛关注。在本文中,我们提出了一种智能的物理攻击(physical attack)方法,通过从外部观察(指用一个天花板上的相机识别Tag获取机器人位置)学习受害机器人(victim robot)的避障机制( obstacle-avoidance mechanism),将受害机器人困在预设位置。我们工作的新颖之处在于,揭示了具有智能和先进设计的基于物理的攻击(physical-based attack)而无需事先了解系统的动力学或访问内部系统,会对移动机器人产生真正的威胁。在传统的网络空间安全中,这种攻击无法通过反措施进行处理。我们提出的攻击方法的基础是主动探索受害者机器人与环境的复杂交互特征,在对其行为进行有限的观察以学习其避障策略。然后,我们提出了最短路径( shortest-path )和hands-off攻击算法,从巨大的运动空间中寻找有效的攻击路径,分别以较低的路径长度和活动时间成本实现诱导受害者机器人到陷阱的目标。证明了算法的收敛性,并进一步推导了攻击性能界限。大量仿真和实物实验证明了所提出的攻击方法的有效性,并呼吁未来对机器人系统的物理威胁和防御策略有进一步的研究。

🏷️Introduction

移动机器人(集群)综合了通信、计算、控制的能力以实现在现实世界的各种操作,可以将其看作一个典型的网络物理系统cyber-physical system (CPS)。不管是单个机器人还是机器人集群,它们在工业和军事领域的应用越来越广泛,因为存在着潜在的恶意外部攻击,他们的安全性变得至关重要。

本文研究了一种新型的针对移动机器人的智能物理攻击方法,不依赖于任何先验知识。攻击者的目标是从外部观察中了解受害者机器人的避障机制,然后利用它将受害者机器人愚弄到预设陷阱中。这个问题的灵感来自机器人与物理环境的内在交互性质及其安全问题。一方面,先前关于移动机器人安全的研究主要是从网络空间的角度进行的[2] [3],而物理攻击较少受到关注,但却非常重要。现实世界中的移动机器人普遍需要与物理环境交互[4]。通过伪装成障碍物接近受害机器人,不可避免地会产生避障行为,为困住受害者机器人提供支持。另一方面,许多防御技术都假定可能的攻击事先是强大的[5]、[6],在获得稳健的安全性能的同时会产生更多成本,例如硬件计算负担。事实上,如果攻击被认为几乎不可能发动,那么就不需要设计复杂的对策以及性能下降,从而更好地指导系统防御设计。所以本文提出的物理攻击方法是很难防御的。

尽管本文中的攻击问题与经典的追击回避问题[7]、[8]、[9]和羊群问题[10]、[11]、[12]有一些相似的特征,但我们指出,它们的应用场景和基本模型公式仍然存在重大差异。首先,这里的物理攻击不仅仅是控制机器人捕捉或跟踪受害者机器人,还要诱导受害者机器人移动到预设的陷阱位置。第二,与前面的工作不同,这些工作通常假设可以获得关于交互模型的全部或部分知识,本文中的攻击问题没有关于受害者机器人的先验知识。首先需要主动学习必要的避障知识,使攻击更具普遍性,并适用于大多数避障机制,这是本文的一个重要而独特的部分。此外,与直接拦截(如导弹制导[13])或解码和操纵通信消息(尤其是当控制通信受到强加密[14]、[15]保护时)相比,本文的物理攻击方法可行性更高、更隐蔽、经济成本更低,带来了严重威胁。

为了系统地设计和评估对移动机器人的智能物理攻击,必须解决三大挑战。

- 首先,攻击者不知道支持攻击的前提信息(如障碍物检测范围和目标位置),这使得传统技术(如参数辨识和模型预测控制)难以建立攻击模型。

- 第二,攻击者和受害者机器人在运动空间中相互影响,难以找到满足攻击要求的可行解空间。

- 第三,即使找到可行的解空间,也很难优化策略设计,以低攻击成本实现最终目的。

本文是[16]中所述初步工作的扩展,提供了模型学习、攻击设计和性能分析的详细和严格处理,以及新颖的仿真结果。本文的主要贡献如下

🏷️主要工作及贡献

- 我们研究了仅利用外部观察而不依赖任何系统动力学的先验信息,对移动机器人进行智能和高级物理攻击的可能性。以通用避障机制为攻击接口,提出了一种包括知识学习和攻击实现的系统攻击方案。

- 我们提出了一种基于有意激励的学习方法来获取避障知识。通过描述避障行为并将攻击者伪装成障碍物,我们演示了如何激发受害机器人的各种避障反应。基于对这一过程的观察,我们建立了反映潜在机制的特征数据对,并通过基于学习的方法进一步回归出受害者机器人的避障机制。

- 我们分别以攻击路径长度和活动周期为目标,设计了两种驱动陷阱攻击算法。我们从下降搜索的角度证明了攻击算法的收敛性。在理论上进一步推导了关于最优代价的算法的性能界限。进行了大量仿真和实际实验,以说明所提出的攻击的有效性。

从更大的意义上讲,本文通过外部观察和激励揭示了系统安全的脆弱性。由于避障行为对于移动机器人与环境交互是必不可少的,因此当机器人事先不知道恶意行为时,很难防御所提出的攻击,因为攻击者在攻击过程中并不总是持续活动,而是间歇性活动。因此,我们的工作为从物理方面探索针对移动机器人的更多潜在和高级攻击奠定了基础,并为指导未来的防御设计提供了更深入的见解。

🏷️Related Work

1 CPS security 网络物理系统的安全性

安全性显示了系统应对恶意行为或意外事件的能力[17]。在文献中,针对移动机器人的攻击主要来自网络空间,大致可分为三类:拒绝服务攻击、重放攻击和欺骗攻击[2]。在这些攻击中,通信信道被阻塞/中断[18],或者控制数据和测量被破坏/改变[19],从而在关键和对抗场景中危及系统。已作出许多努力来设计相应的对策。例如,Pasqualetti等人[6]描述了无法检测和无法识别的攻击,并设计了相应的检测过滤器。Chang等人[20]考虑了受攻击节点集可以随时间变化的安全估计问题。考虑到存在机器人故障[21]、[22]或不良队形变化[23]、[24],开发了机器人队形的运动同步方法。在[25],部署了一组机器人来驱赶敌方空中袭击者,以保护安全关键的基础设施。然而,现有的大多数研究都依赖于这样的假设,即攻击者具有一些知识或可以访问机器人系统。例如,恶意代理知道系统结构或节点状态[5],或者通过网络传输的数据包已损坏[26]、[27]。然而在实际中,这些假设可能不再成立。

近年来,出现了隐形物理攻击,并带来了真正的威胁,其中物理组件的目标是危害甚至摧毁系统。例如,GPS传感器读数可能会受到GPS欺骗攻击的干扰[28],[29]。人为设计的噪声会改变陀螺仪传感器数据,导致无人机坠毁[30]。存储在内存(例如EEPROM、闪存)中的重要信息也可能在设备没有任何损坏的情况下因加热存储单元而导致损坏[31]。与网络攻击相比,这些物理攻击具有更广泛的适用性,而传统来自计算机安全社区的检测技术通常无法有效处理这些问题[1]。请注意,这些新出现的物理攻击仍然是初级的,不够智能。例如,攻击是利用传感器的独特机制针对特定传感器设计的,无法推广。此外,这些旨在干扰系统性能的物理攻击是以“开环”方式设计的,没有复杂的控制设计,这促使本文的工作以智能的方式研究可能的物理攻击。

2 Obstacle-avoidance mechanism 避障机制

目前已经有多种移动机器人的避障方法,例如,基于势场的方法[32]、基于遗传算法的方法[33]、基于模糊逻辑的方法[34]、基于神经网络的方法[35]等(详细综述见[36]和[37])。根据其算法特点,类似于[38],我们将这些算法分为两种主要类型:确定性方法(例如,人工势方法(APM)、基于学习的方法);基于搜索的方法(例如,动态窗口方法(DWA)、遗传方法、进化算法)。前者是确定的模型驱动,针对当前情况的解决方案是唯一的,并且可以快速找到。后者的核心思想是搜索所有可行解,并根据评价函数选择最佳解,这是一个耗时的过程。无论采用何种避障方法,其本质都是绕过障碍物并调整到目标点的轨迹,其避障策略会直接泄漏给外部观察(external observation)。我们的攻击算法设计充分利用了这一特性。

总之,在事先不了解系统的情况下,从物理方面研究智能通用的攻击手段仍然是一个开放并关键的问题。

🏷️准备与问题描述

这章内容主要是机器人运动学模型与避障机制建模

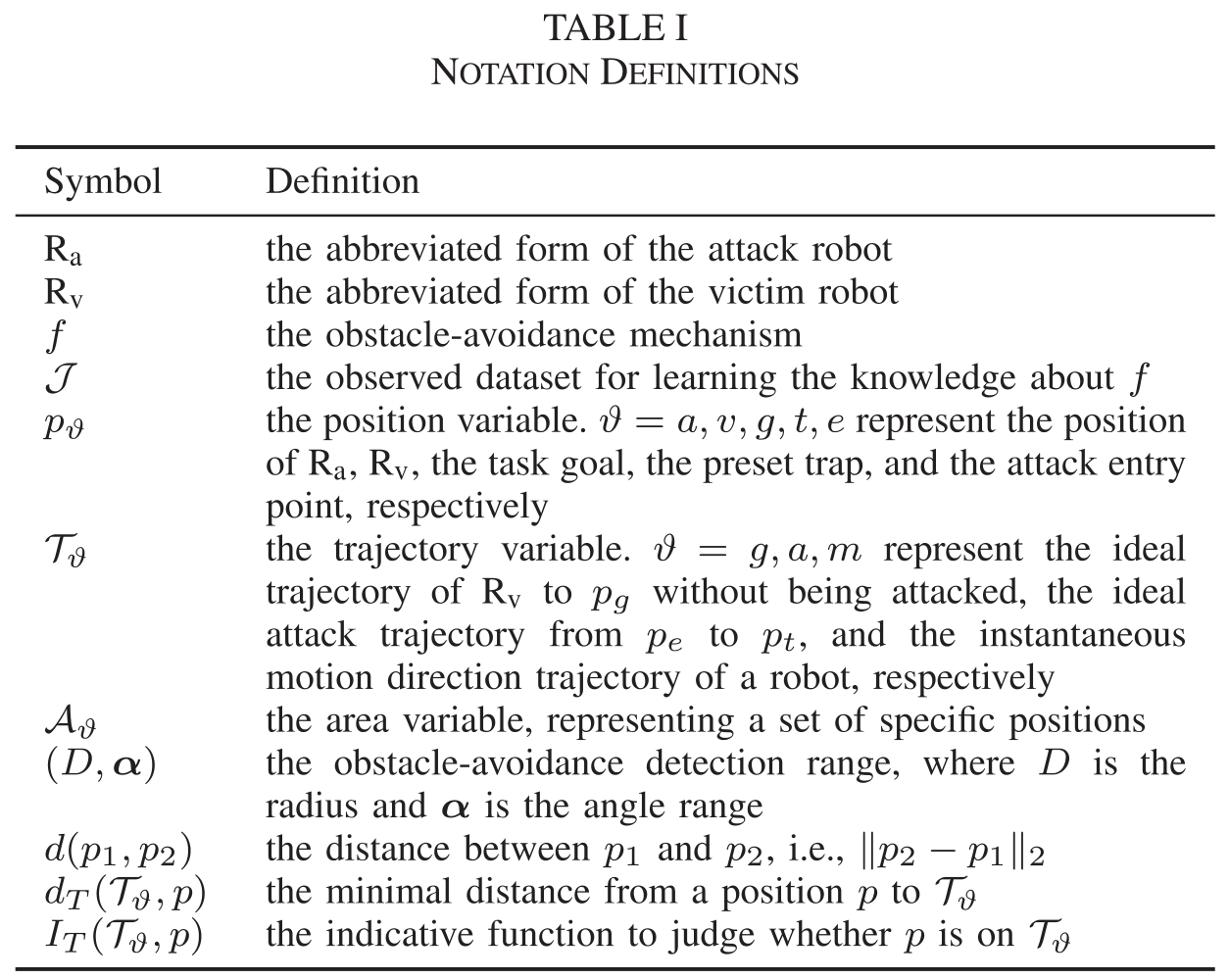

1 符号定义

2 移动机器人的运动控制建模

作者分别讨论了非完整状态约束(nonholonomic)的机器人和完整状态约束(holonomic)的机器人的运动学模型,并指出由于nonholonomic的机器人瞬时运动受到横向限制,这使得其控制比后者更具有挑战性。使用$p=[x,y,\theta]$来表示一个机器人的姿态,运动直接由线速度$v$和角速度$\omega$控制,运动学模型可以表示为

离散形式:

$T$为控制周期,控制目标为输出线速度$v$和角速度$\omega$使机器人趋近于目标姿态$p^=[x^,y^,\theta^]$,定义瞬时姿态误差$p_e=p^*-p=[x_e,y_e,\theta_e]$,控制器可以被表示为:

通过设计$ u_v和u_\omega

$来控制线速度$v$和角速度$\omega$跟踪误差$\left|p_{e}\right|_{2}$趋近零。上式表示了nonholonomic机器人的一般一阶运动控制模型。

考虑到nonholonomic的非线性特性,通常引入“hand”位置$h = [x_h,y_h]=[x+{d_h}cos\theta,y+{d_h}sin\theta]$来简化运动模型

对于holonomic的机器人,可以直接输出$v_x,v_y$来控制运动。本文设计的智能攻击方法两种类型都适用,作者主要通过对nonholonomic机器人的攻击来阐述自己的工作,其结果可以很容易推广到nonholonomic机器人上。

3 避障行为建模

用$p_{ob}和v_{ob}$分别表示障碍物的姿态和速度,考虑到避障行为主要由机器人与障碍物之间的相对姿态和运动决定,我们把避障行为表达成:

$p^$是由特定任务确定的瞬时期望姿态(例如编队控制任务中leader的目标姿态),在一些算法设计中,如果$p_{ob}$非常接近$p$,$p^-p$将被忽略。在上式中的避障行为有两个性质:

- $f$是有界的,只有当障碍物出现在机器人的检测范围内才起作用。

其中$\mathcal{A}_{d}(p)$表示$\mathrm{R}_{\mathrm{v}}$在$p$处的能够检测到障碍物的范围区域

- 避障行为的方向性,$\mathcal{T}_{\vartheta}$表示把一个$X-Y$平面分成两个区域($ \mathcal{T}_{\vartheta}^{+}和 \mathcal{T}_{\vartheta}^{-} $)的一条简单曲线,

在k时刻障碍物出现在了机器人的检测范围内,$\mathcal{T}_{m}(p(k)$表示k时刻机器人瞬时运动的切线,那么k+1时刻机器人的位置应该朝远离障碍物的方向移动,即机器人以$\mathcal{T}_{m}(p(k)$为界向障碍物的另一侧移动,可以抽象成下面这个公式:

在一些复杂情况下,避障建模有一些值得注意的地方:

- 几何形状:在实际上,传感器将障碍物检测为一系列稠密点,避障行为基于按特定规则处理这些点。例如,它们可以用简单的凸面几何形状(例如一个圆)来表示,机器人以特定半径围绕其圆心移动。

- 多障碍物:当涉及多个障碍物时,机器人需要评估它们综合的影响。在一些简单的情况下,机器人可以直接以最近的障碍物作为避障依据,可以始终保证安全的避让行为。

假设1:受害者机器人的避障检测范围是局部的,它使用的避障算法可以用上述模型建模,并且是单射(injective map)。此外,攻击机器人对受害者机器人的观测值受到高斯噪声的干扰。

4 问题描述

本文工作适用于一个具有代表性的应用场景:$\text {R}_\text{v}$(受害者机器人)正在执行目标任务,并且能够通过$f$进行避障,$\text {R}_\text{a}$(攻击机器人)的目标是通过伪装成障碍物将$\text {R}_\text{v}$诱骗至预设陷阱$ p_t $中,$\text {R}_\text{a}$还具有观察$\text {R}_\text{v}$的能力,在观察的过程中$\text {R}_\text{a}$的移动受限。将$\mathcal{J}$定义为反映$f$的观测数据,整个攻击问题可以转换成以下数学问题:

(1)学习$f$:通过对$\text {R}_\text{v}$的观测数据$\mathcal{J}$,寻找体现$f$的映射关系$\phi$ by solving

(2)攻击策略设计:给定$\hat{f}$,寻找一组攻击输入$\boldsymbol{u}_{a, 0: H}$,驱使$\mathrm{R}_{\mathrm{v}}$到预设陷阱$ p_t

$ by solving

其中,$C_{\vartheta}$是攻击代价(例如攻击路径长度或活动周期),$\delta \geq 0$是攻击终止的条件

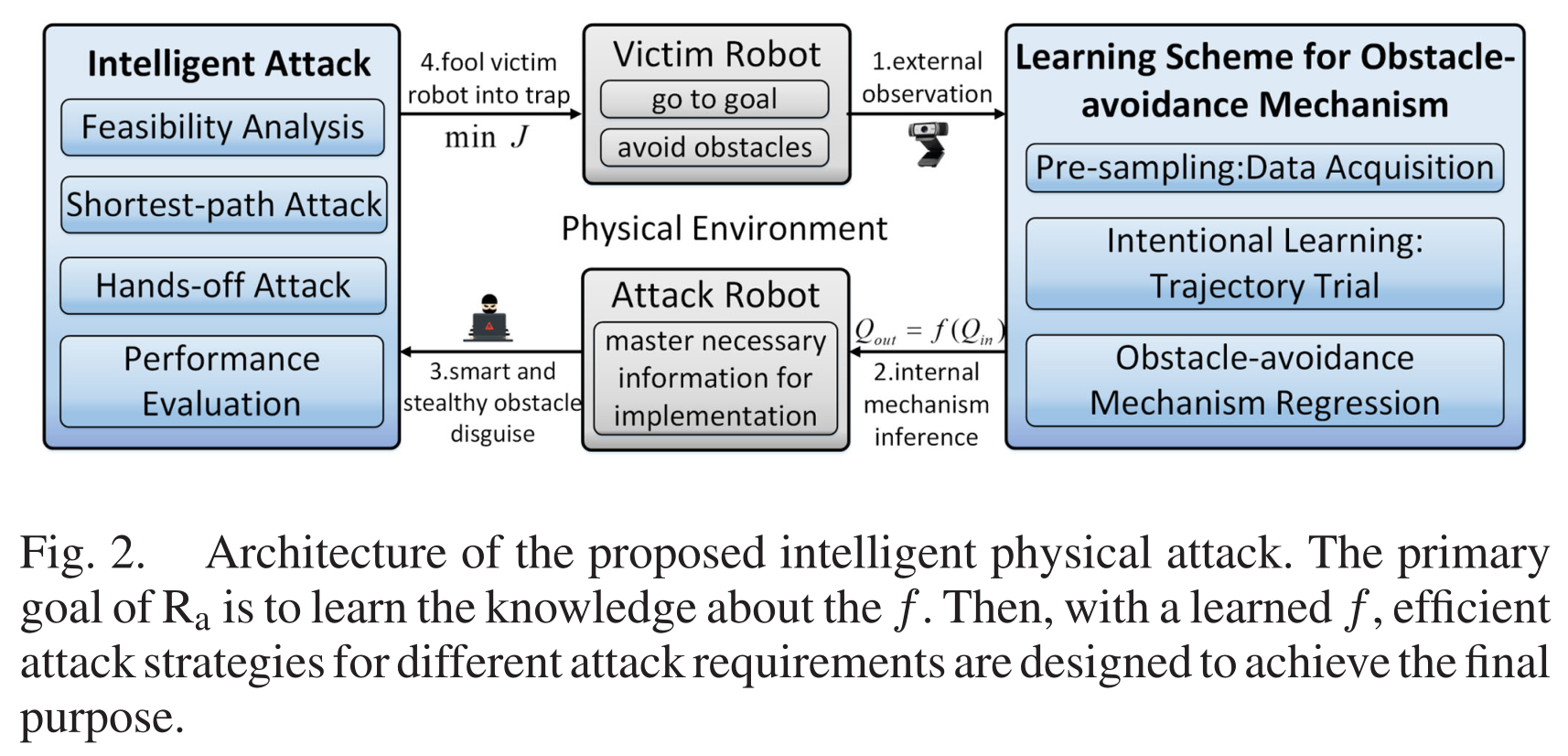

对于问题(1),关键在于捕捉移动机器人在检测到障碍物后如何调整其轨迹的基本准则,并根据观测数据构建相应的数据集。对于问题(2),由于$f$的隐式形式,很难获得最优解析解。然而,借鉴基于抽样的方法[50]、[51]的思想,我们能够设计有效的算法,以获得不同攻击成本下的次优解。本文的整体框架如图2所示:

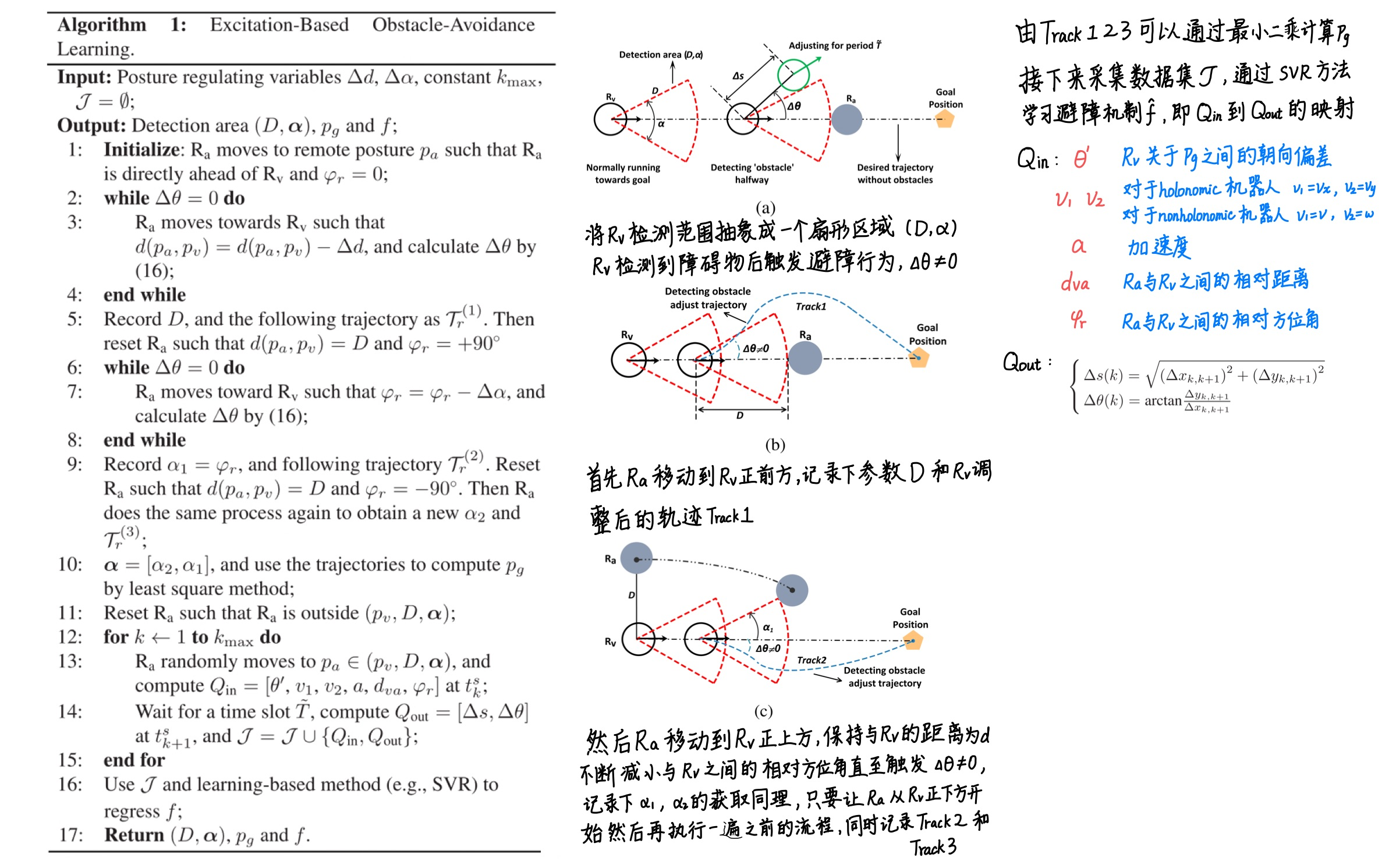

🏷️ 避障机制的学习方案

- 预采样:理想情况下,可以在三个连续位置采样获得$\mathrm{R}_{\mathrm{v}}$的瞬时运动信息(例如朝向、线速度、角速度和加速度)。这是以下步骤的基础。

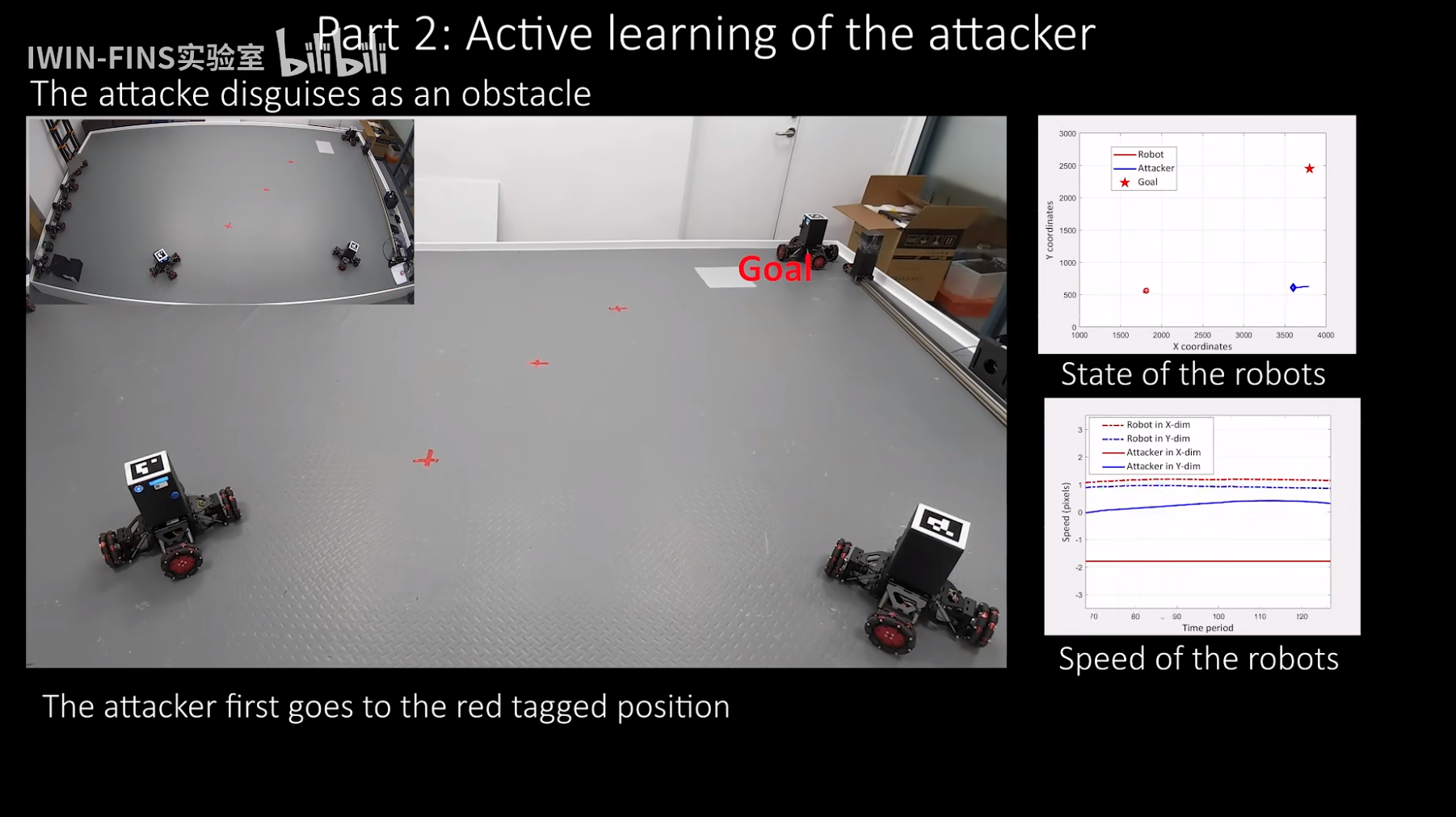

- 故意刺激:$\mathrm{R}_{\mathrm{a}}$伪装成障碍物主动接近$\mathrm{R}_{\mathrm{v}}$,故意刺激$\mathrm{R}_{\mathrm{v}}$,引导$\mathrm{R}_{\mathrm{v}}$产生各种避障行为,丰富观察结果,以了解其潜在的避障机制。

- 建模学习:基于激励试验收集的数据,$\mathrm{R}_{\mathrm{a}}$计算能够体现$\mathrm{R}_{\mathrm{v}}$避障行为的特征变量,并通过基于学习的方法(例如SVR、RRT)回归其潜在的避障机制。

1 预采样:数据获取

将机器人在一个控制周期$T$内的轨迹近似为1条直线,设$\mathrm{R}_{\mathrm{a}}$的采样周期$\tilde{T}=N T$,经历3次连续的采样后,$\mathrm{R}_{\mathrm{v}}$的瞬时运动变量估计为:

对于holonomic机器人这步会更简单并且精度更高,在这里做一个统一声明,对于nonholonomic机器人,$v_{1}=v, v_{2}=\omega$;对于holonomic机器人,$v_{1}=v_x, v_{2}=v_y$

Remark 2:在实际中,运动控制周期$T$非常小(例如0.05 s或0.1s,采样周期$\tilde{T}$由$\mathrm{R}_{\mathrm{a}}$搭载的传感器决定。如果设置一个比较大的采样周期,并在一段短时间内(例如$T$)计算平均值可以大大降低观测噪声的影响。这不会影响以下对学习和攻击程序的分析。

$\mathrm{R}_{\mathrm{a}}$需要先判断$\mathrm{R}_{\mathrm{v}}$属于哪种类型,可以通过检查其运动轨迹的顺滑程度来判断,holonomic机器人的速度方向可以突变,而nonholonomic机器人的运动方向遵守严格的运动学约束。基于上述公式,$\mathrm{R}_{\mathrm{a}}$可以随时获取$\mathrm{R}_{\mathrm{v}}$的瞬时运动信息。这构成了以下步骤的基础。

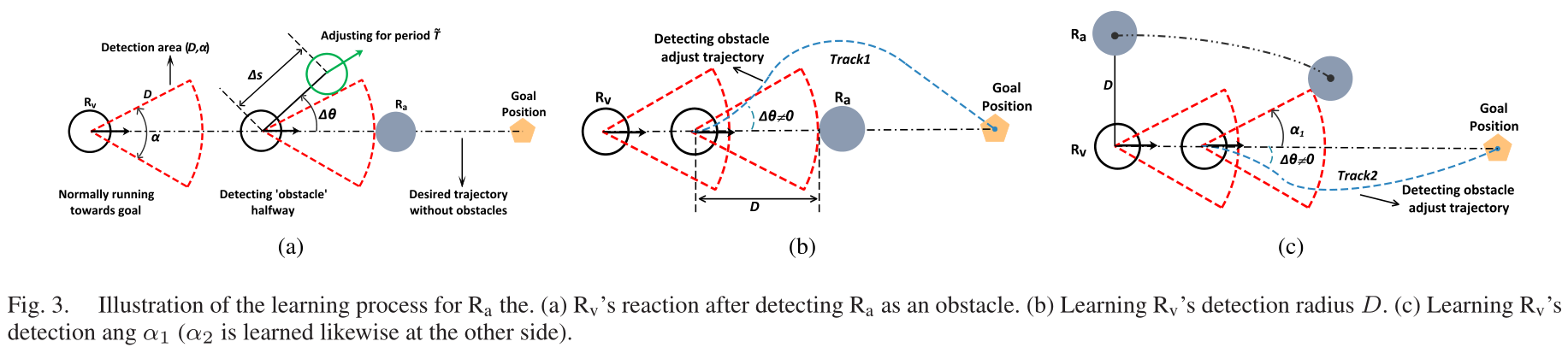

2 故意激励:轨迹试验

本文将$\mathrm{R}_{\mathrm{v}}$的障碍物检测区域模拟成扇形区域,将其参数化表达为$(D, \boldsymbol{\alpha})$。$\mathrm{R}_{\mathrm{a}}$通过相邻的两次观测计算$\mathrm{R}_{\mathrm{v}}$的位置变化$\Delta s$和朝向变化$\Delta \theta$。

$\mathrm{R}_{\mathrm{v}}$的目标点为$p_g$,在没有检测到障碍物时,$\mathrm{R}_{\mathrm{v}}$会径直地朝$p_g$运动,此时$\Delta \theta = 0$,因此当$\mathrm{R}_{\mathrm{a}}$进入$\mathrm{R}_{\mathrm{v}}$的检测范围后,$\Delta \theta \neq 0$。在$\mathrm{R}_{\mathrm{v}}$的朝向稳定后,$\mathrm{R}_{\mathrm{a}}$会记录其调整后的直接朝$p_g$运动的轨迹。

在没有障碍物的情况,直接朝目标点运动(走直线)是最有效的,也有一些工作指定机器人沿着平滑曲线到达目标,我们可以利用经典的多项式拟合方法来近似$\mathrm{R}_{\mathrm{v}}$直接向目标点运动时的轨迹,设多项式的最高阶数为$n_p$,$\tilde{\boldsymbol{x}}=\left[x^{n_{p}}, x^{n_{p}-1}, \ldots, x^{0}\right]^{\top}$,$\boldsymbol{P} \in \mathbb{R}^{n_{p}+1}$是关于$\tilde{\boldsymbol{x}}$的系数向量,轨迹上的一个点可以建模为:

其中$ \eta $是高斯噪声。为了简化,本文只考虑一阶轨迹(即直线)。假设一共记录了$n_z$组轨迹,其中第$l_{th}$个轨迹满足:

$n_t$是此轨迹中记录的观测数据的数目,令$d_{T}\left(\mathcal{T}_{\vartheta}, p\right)$表示从一个位置$p$到一个轨迹$\mathcal{T}_{\vartheta}$的最短距离,那么有以下结论:

Theorem 1(受害者的目标点$p_g$的位置估计):给定轨迹$\mathcal{T}_{r}^{(l)}$中$n_t$个观测数据,当$n_{t} \rightarrow \infty$时,$\mathcal{T}_{r}^{(l)}$会经过$p_g$,即

给定$n_z$组轨迹$\left\{\mathcal{T}_{r}^{(l)}, l=1, \ldots, n_{z}\right\}$,设$\hat{p}_{g}\left(n_{z}\right)$为$p_g$的最小二乘估计量,当$n_{z} \rightarrow \infty$时,$p_g$可以被准确估计,即

Remark 3: 定理1说明了记录的轨迹如何影响精度,每条轨迹中采样点的数量$n_t$决定了$p_g$与这条轨迹有多接近;获取的轨迹数量$n_z$决定了,$p_g$和估计值$\hat{p}_g$有多接近。

3 避障模型学习:基于SVR的方法

在上一步中,可以获取到$\mathrm{R}_{\mathrm{v}}$的检测范围$(D, \boldsymbol{\alpha})$和目标点$p_g$。在这步,$\mathrm{R}_{\mathrm{a}}$主动出现在$\mathrm{R}_{\mathrm{v}}$的检测范围中,并记录以下参数:$\mathrm{R}_{\mathrm{a}}$与$\mathrm{R}_{\mathrm{v}}$之间的相对距离$d_{va}$,相对方位角$\varphi_{r}$,$\mathrm{R}_{\mathrm{v}}$与$p_g$之间朝向偏差$\theta^{\prime}$。一旦$\mathrm{R}_{\mathrm{a}}$被$\mathrm{R}_{\mathrm{v}}$检测到,$\mathrm{R}_{\mathrm{a}}$在下一次采样周期中保存两组数据:

避障机制数据集$\mathcal{J}$可以表示为:

本文使用机器学习中的SVR方法来回归受害者机器人的避障机制,在数据量不大的情况下,具有良好的非线性回归性能和较强的泛化能力。作者指出由于在一个采样周期$\tilde{T}$内,$Q_{out}$的观测噪声会不断积累,所以该学习方法会在$\tilde{T} \rightarrow T$时达到最理想的性能。另外尽管学习得到的$\hat{f}$是从$Q_{in}$→$Q_{out}$的映射,但这个模型不一定是满射或单射,换句话说,我们不能通过$\hat{f}$从$Q_{out}$反推$Q_{in}$。

不同避障算法的回归差异体现在回归模型的内部结构和参数上。通过$\mathrm{R}_{\mathrm{a}}$学习到受害者障碍机制,使其不依赖于强假设(攻击者从一开始就知道受害者的信息)。

🏷️攻击策略设计与分析

1 攻击思路与可行性分析

本文提出了两种攻击策略:最短路径攻击(shortest-path attack),放手攻击(Hand-off)。最短路径攻击旨在设计$\mathrm{R}_{\mathrm{a}}$最小的路径代价将$\mathrm{R}_{\mathrm{v}}$驱赶至预设陷阱,$\mathrm{R}_{\mathrm{a}}$此过程中始终处于活动状态,然而这在某些情况是不可取的,例如$\mathrm{R}_{\mathrm{v}}$如果长时间检测到附近有障碍物可能会导致其异常报警,甚至改变控制策略。为了减轻这些影响并使$\mathrm{R}_{\mathrm{a}}$的攻击过程更隐蔽,我们进一步提出了一种不干预的攻击策略,即”Hands-off”。“放手”是指在一段时间间隔内,对$\mathrm{R}_{\mathrm{v}}$的干预效果可以精确地保持为零,目的是获得最稀疏的控制或对$\mathrm{R}_{\mathrm{v}}$的最小主动干扰[56],[57]。

(后面的内容主要是关于攻击切入点的选取,和两种攻击算法的实现,攻击效果分析,直接看论文吧…

🏷️总结

这篇文章的创新点在于提出了一种新颖的智能物理攻击框架。智能主要体现在攻击者可以主动在线学习被害者的避障策略,从而发动攻击,驱赶被害者到预设陷阱处。本文设计了两种攻击策略:最短路径攻击(优点在于攻击者的路径代价小,但攻击者一直处于活动状态),Hands-off攻击(优点在于攻击者的活动时间短,攻击更加隐蔽,但攻击路径成本更高)。本文与传统的追逃问题,羊群放牧问题具有一些相似之处,但基本的模型公式和应用场景又有较大差异,主要体现在:

- 任务场景:本文提出的攻击方法旨在利用受害者的避障机制将其驱动到预设的陷阱位置。在追逃问题中,追捕者的目的是抓捕逃犯,其控制目标是紧密跟踪逃犯或对逃犯形成包围。

- 模型知识:本文的最大的创新之处在于攻击者可以利用机器学习方法主动学习受害者的避障机制,然后利用所学模型设计攻击模式驱使其进入陷阱。而现有的大多数工作很少讨论关于模型知识的问题,例如,许多羊群放牧问题的工作都假定机器人的交互模型是事先已知的,而本文不需要提供先验知识,这也体现了智能。

- 模型类型:本文提出的攻击框架不是针对受害者机器人的特定动态模型而专门定制的。追逃问题中机器人的动力学通常被建模为一个多智能体LTI系统。而在羊群问题中,其动力学模型通常具有特定的函数形式(例如势能函数),并且只取决于放牧机器人和羊群机器人的位置。

一些问题:

(1)这篇工作在学习受害者机器人的避障策略时,将其检测范围假设成一个扇形,并且学习的避障机制是作者事先规定的一组输入量到输出量之间的映射,这未免还是假设性太强了。

(2)整套理论的基础都是基于无障碍的场景进行,其中避障机制的映射里没有关于障碍物的信息,只有与目标点之间的信息,是不是学习避障策略时就没有考虑有障碍的环境,而只是在理想的无障碍环境中进行主动观测。还有对于攻击切入点的选取,似乎也没有考虑障碍物的存在,但实物实验中又有障碍物,不知道这里面做了什么处理。整套理论对场景的假设太过理想了,实物实验的场景还是太干净了,这套理论是否强依赖于场景,如果换个场景是否要增加许多额外的处理,还能保证正常功能吗,我觉得这些是以后可以考虑解决的问题。

(3)实物实验中,攻击机器人的运动速度明显快于受害机器人,在拦截这个动作本身上就占优势,如果两个机器人速度一样,或者受害者机器人的速度快于攻击机器人,那还能成功地完成驱赶吗?这个时候我觉得就可以体现协同的优势了,两辆机器人协同的话,我觉得是能够成功驱赶一个比他俩更快的受害机器人到达陷阱的。(思想主要来源于动物世界一群鬣狗可以群殴一头狮子)

(4)因为需要对受害者机器人进行观测来计算其避障机制,这篇工作使用了屋顶的一个相机作为外部观察,配合二维码来提高观测精度。对于智能体来说,我们更加希望它能够有充分的自主智能,可不可以不依赖这些外部传感器,而仅依靠自身传感器来完成任务,甚至不需要对其运动和避障进行建模,仅获取必要的速度位置等信息,结合场景的地图结构来进行决策,快速完成驱赶任务。

(5)学习避障机制和进行攻击是在不同周期下进行,也就意味着需要先观测一遍学完了才能进行攻击,在这个过程中机器人可能已经到达了目标点,这对于很多情况来说是不可取的,例如在战场上拦截一个十分危险的自爆机器人。